导入数据集¶

受支持的文件类型¶

Driverless AI 支持以下数据集文件格式:

arff

avro

bin

bz2

csv(请参阅下方注释)

dat

feather

gz

jay(请参阅下方注释)

orc(请参阅下方注释)

parquet(请参阅下方注释)

pickle / pkl(请参阅下方注释)

tgz

tsv

txt

xls

xlsx

xz

zip

注解

压缩的 Parquet 文件通常是用于 Driverless AI 的最有效文件类型。

仅在通过字节顺序标记 (BOM) 实现时,方可支持采用 UTF-16 编码的 CSV。如果没有 BOM,则会将数据集作为 UTF-8 文件读取。

对于 ORC 和 Parquet 文件格式,如果您选择导入多个文件,则这些文件将作为多个数据集导入。如果您选择 ORC 或 Parquet 文件的文件夹,则此文件夹将作为单个数据集导入。Spark/Hive 等工具可将数据作为多个 ORC 或 Parquet 文件导出,这些文件将存储于用户定义名称的目录中。例如,如果您以

Spark dataFrame.write.parquet("/data/big_parquet_dataset")导出,Spark 将创建一个文件夹 /data/big_parquet_dataset ,其中包含多个 Parquet 文件(具体取决于输入数据集中的分区数)和元数据。导出 ORC 文件的结果类似。对于 ORC 和 Parquet 文件格式,当引入的 ORC 或 Parquet 文件具有作为数组元素的结构时,您可能会收到错误提示:”Failed to ingest binary file with ORC / Parquet: lists with structs are not supported” (无法通过 ORC/Parquet 获取二进制文件:不支持带有结构的列表)。这是因为 PyArrow cannot handle a struct that’s an element of an array.

Sparkling Water 提供了针对扁平化 Parquet 文件的解决方法。详细信息,请参阅 我们的 Sparkling Water 解决方案 。

要使用具有列表类型列的 Parquet 文件,

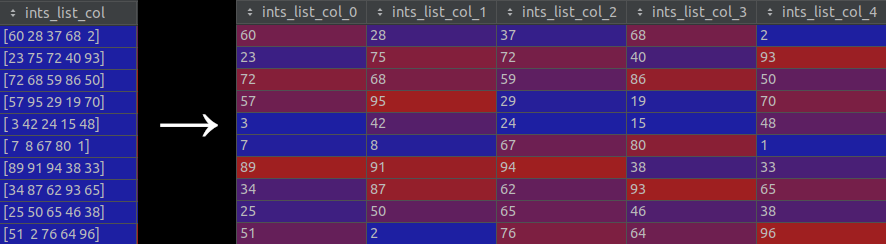

data_import_explode_list_type_columns_in_parquetconfig.toml option 必须设置为true.(注意默认会禁用此设置。)启用此选项时,列表类型列将 “拆分” 成单独的新列。换言之,单元格中的每个列表被拆分成单独的项,然后使用这些项创建新列。请参阅下图以便直观了解此过程:

通过在 添加数据集(或拖放) 下拉菜单中选择 数据插件 URL 或 上传数据插件 ,您可以使用 Python 脚本文件(自定义插件)创建新数据集。如果您选择 数据插件 URL 选项,则 URL 必须指向此文件的 HTML 或原始版本、GitHub 资料库或树或者本地文件。此外,您可以通过使用自定义插件修改现有数据集来创建新数据集。请参阅 通过自定义数据插件进行修改 以了解更多信息。通过插件创建或添加的数据集将另存为 .jay 文件。

为避免可能出现的错误,建议将 pickle 文件转换为 CSV 或 .jay 文件。以下示例展示了如何使用数据表将 pickle 文件转换为 CSV 文件。

import datatable as dt import pandas as pd df = pd.read_pickle("test.pkl") dt = dt.Frame(df) dt.to_csv("test.csv")

添加数据集¶

您可以使用以下方式之一添加数据集:

将文件从本地计算机直接拖放至本页面。请注意,此方式目前适用于小于 10GB 的文件。

或

点击 添加数据集(或拖放) 按钮上传或添加数据集。

请注意:

默认启用“上传文件”、“文件系统”、HDFS、S3、“数据插件 URL”和“上传数据插件”,若要禁用,将其从 config.toml 文件的

enabled_file_systems设置中移除即可。(请参阅 使用 config.toml 文件 一节,了解更多信息。)如果禁用“文件系统”,Driverless AI 将默认开启本地文件浏览器。

如果在启动 Driverless AI 时即已启用了 Azure Blob Store 、BlueData Datatap、Google Big Query、Google Cloud Storage、KDB+、Minio、Snowflake 或 JDBC 的数据连接器,则这些选项将显示在 添加数据集(或拖放) 下拉菜单中。请参阅 启用数据连接器 一节,了解更多信息。

当指定使用 数据插件 URL 添加数据集时,URL 必须指向此文件的 HTML 或原始版本、GitHub 资料库或树或者本地文件。当通过插件添加或上传数据集时,该数据集将保存为 .jay 文件。

数据集必须为带分隔符的文本格式。

Driverless AI 可检测以下分隔符:,|;t

导入文件夹时,将整个文件夹及其所有内容作为单个文件读取至 Driverless AI 中。

导入文件夹时,文件夹中的所有文件必须有相同数量的列。

如果您尝试通过 Windows 上的数据连接器导入文件夹,若此文件夹包含没有文件扩展名的文件,则导入将会失败(由此产生的错误通常与上述注意事项有关)。

完成后,数据集将显示在“数据集概述”页面中。点击数据集打开子菜单。在此菜单中,您可以指定重命名、可视化、拆分、下载或删除数据集以及查看数据集的详细信息。请注意:您不能删除活动实验所使用过的数据集,必须先删除实验。