在 NVIDIA GPU Cloud/NGC 注册表上安装¶

以下 NVIDIA DGX 产品支持使用 Driverless AI,并且每个平台的安装步骤相同。

环境¶

提供者 |

GPU |

最小内存 |

适用于 |

|---|---|---|---|

NVIDIA GPU Cloud |

是 |

正式使用 |

|

NVIDIA DGX-1/DGX-2 |

是 |

128 GB |

正式使用 |

NVIDIA DGX 工作站 |

是 |

64 GB |

正式使用 |

安装 NVIDIA NGC 注册表¶

请注意:这些安装步骤假设您在 NVIDIA DGX 计算机上运行 Driverless AI。Driverless AI 仅在 DGX 计算机的 NGC 注册表中可用。

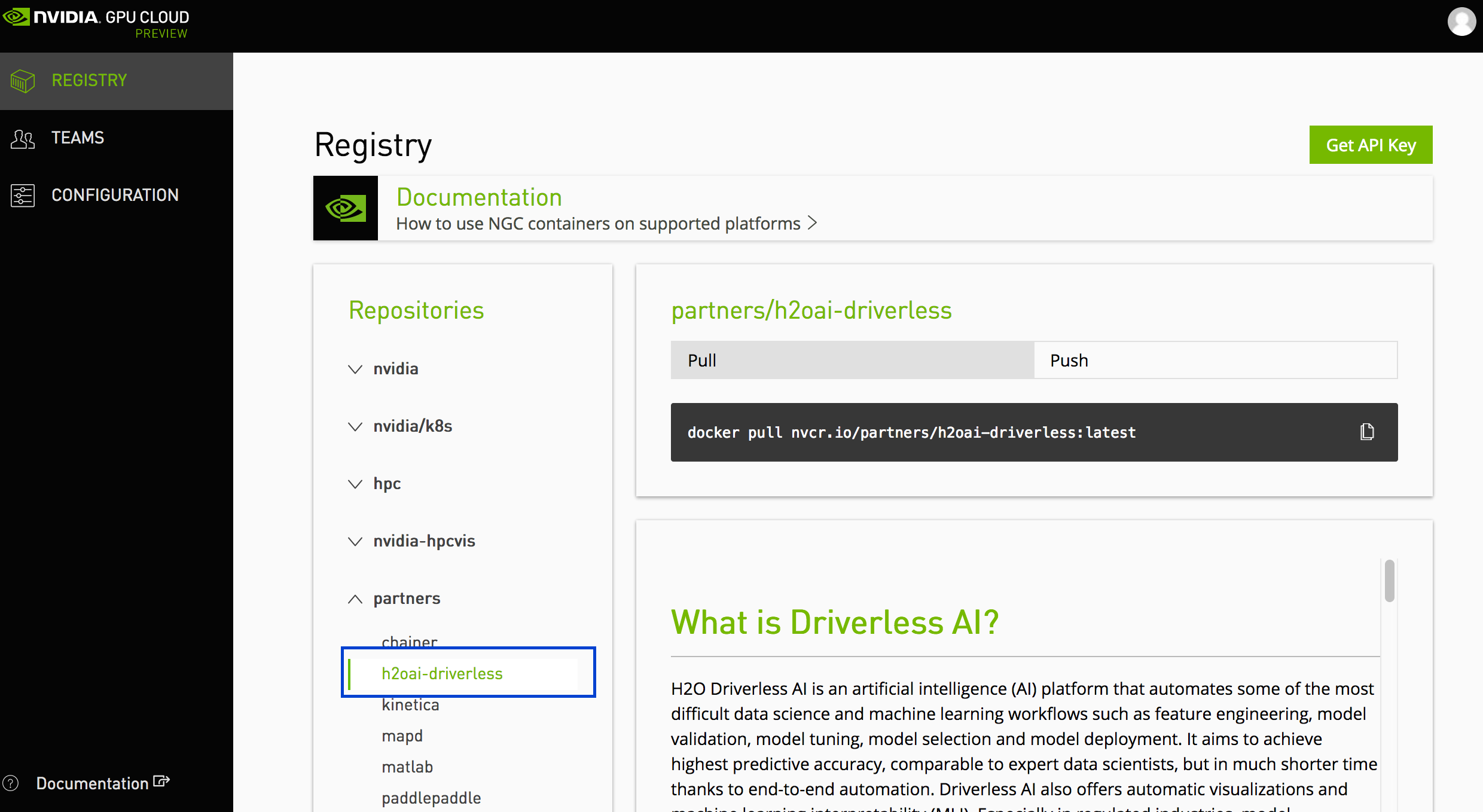

通过 https://ngc.nvidia.com/registry 登录您的 NVIDIA GPU Cloud 账户。(请注意,NVIDIA 不再为 NVIDIA Compute 提供支持。)

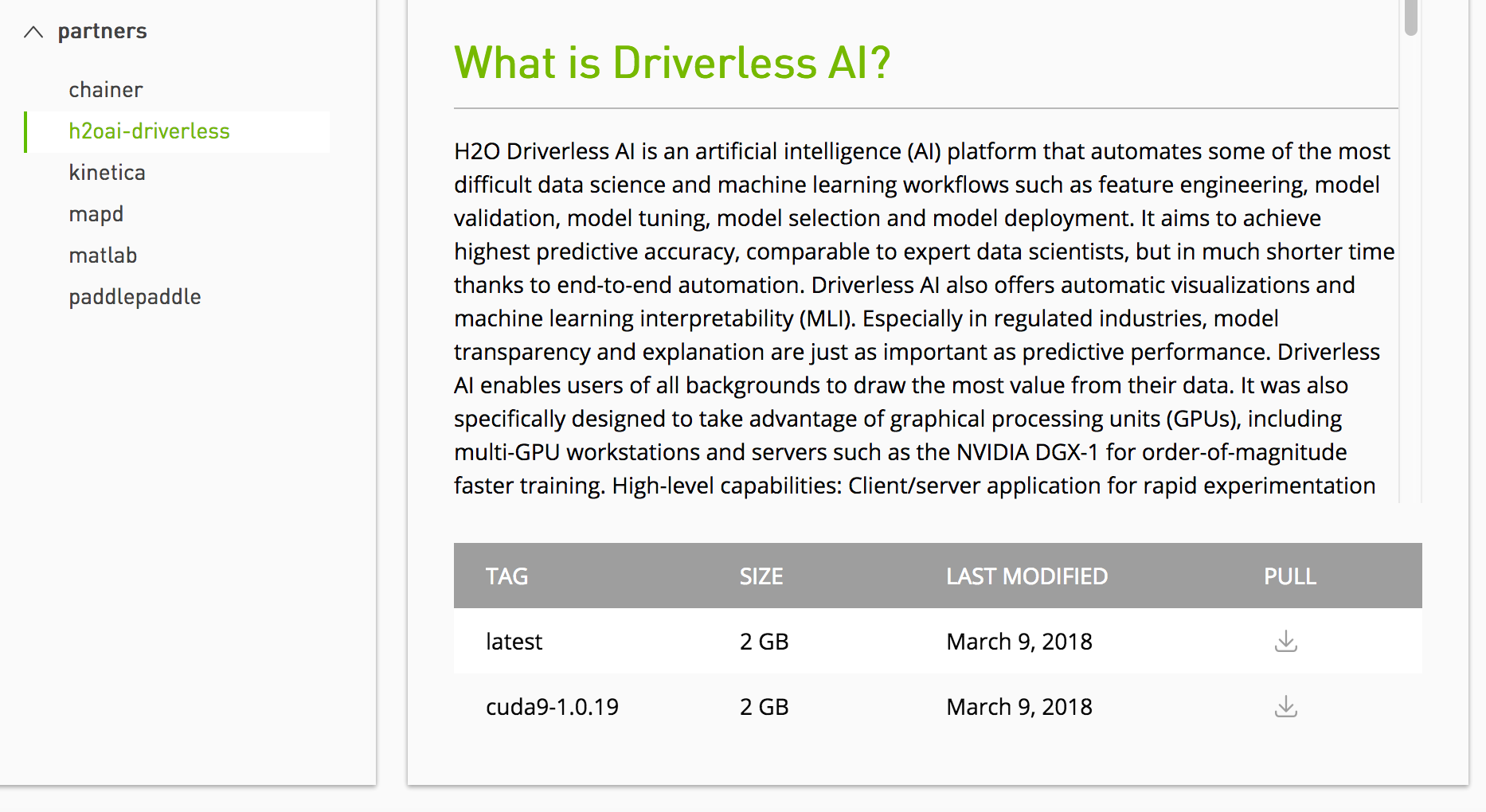

在 注册表 > 合作伙伴 菜单中,选择 h2oai-driverless 。

在屏幕底部,选择一个 H2O Driverless AI 标签以检索 pull 命令。

在 NVIDIA DGX 计算机上,打开命令提示符,然后使用指定的 pull 命令来获取 Driverless AI 映像。例如:

docker pull nvcr.io/nvidia_partners/h2o-driverless-ai:latest

在主机上设置相应 Driverless AI 版本的目录:

# Set up directory with the version name mkdir dai-1.10.1.2

在主机上设置数据、日志、许可证和 tmp 目录:

# cd into the directory associated with the selected version of Driverless AI cd dai-1.10.1.2 # Set up the data, log, license, and tmp directories on the host machine mkdir data mkdir log mkdir license mkdir tmp

此时,您可以将数据复制到主机上的 data 目录中。数据将在 Docker 容器内可见。

启用 GPU 的持久模式。请注意,仅需运行一次即可。更多信息,请查阅以下网页:http://docs.nvidia.com/deploy/driver-persistence/index.html。

sudo nvidia-smi -pm 1

运行

docker images以查找新的映像标签。启动 Driverless AI Docker 映像,并将下方标签替换为映像标签。根据您所安装的版本,使用

docker run --runtime=nvidia(>= Docker 19.03) 或nvidia-docker(< Docker 19.03) 命令。注意,从 1.10 版本开始,DAI Docker 映像使用内部tini运行,相当于使用 docker 中的--init。如果启动命令中同时启用了这两项,tini 将输出一条(无害的)警告消息。

我们推荐 docker 启动命令中使用

--shm-size=256m。但如果用户打算广泛构建 image auto model ,则推荐在 Driverless AI docker 命令中使用--shm-size=2g。请注意:可使用

docker version来检查您使用的 Docker 版本。# Start the Driverless AI Docker image docker run --runtime=nvidia \ --pid=host \ --rm \ --shm-size=256m \ -u `id -u`:`id -g` \ -p 12345:12345 \ -v `pwd`/data:/data \ -v `pwd`/log:/log \ -v `pwd`/license:/license \ -v `pwd`/tmp:/tmp \ h2oai/dai-centos7-x86_64:1.10.1-cuda11.2.2.xx# Start the Driverless AI Docker image nvidia-docker run \ --pid=host \ --rm \ --shm-size=256m \ -u `id -u`:`id -g` \ -p 12345:12345 \ -v `pwd`/data:/data \ -v `pwd`/log:/log \ -v `pwd`/license:/license \ -v `pwd`/tmp:/tmp \ h2oai/dai-centos7-x86_64:1.10.1-cuda11.2.2.xxDriverless AI 将开始运行:

-------------------------------- Welcome to H2O.ai's Driverless AI --------------------------------- - Put data in the volume mounted at /data - Logs are written to the volume mounted at /log/20180606-044258 - Connect to Driverless AI on port 12345 inside the container - Connect to Jupyter notebook on port 8888 inside the container

使用浏览器连接至 Driverless AI:

http://Your-Driverless-AI-Host-Machine:12345

停止 Driverless AI¶

使用 Ctrl+C 停止 Driverless AI。

升级 Driverless AI¶

在 NVIDIA DGX 系统上升级 Driverless AI 的步骤与安装步骤相似。

警告:

此版本不支持 1.7.0 及更低版本的实验和 MLI 模型。

实验、MLI 和 MOJO 存储于 Driverless AI tmp 目录中,并且在 Driverless AI 升级时不会自动升级。我们建议您在升级前采取以下措施。

升级前构建 MLI 模型

升级前构建 MOJO 管道。

升级前停止 Driverless AI 并备份 Driverless AI tmp 目录。

如果在升级 Driverless AI 前未在务必模型上构建 MLI,则升级后将不能在该模型上查看 MLI。升级前,请务必在您想要在未来版本中继续进行解释的模型上运行 MLI 作业。如果当前版本的解释模型列表中含有此 MLI 作业,则在升级后将保留。

如果在升级 Driverless AI 前未在模型上构建 MOJO 管道,则升级后将不能在该模型上构建 MOJO 管道。升级前,请务必在所需的全部模型上构建 MOJO 管道,然后备份 Driverless AI tmp 目录。

在升级过程中,将从 /etc/dai/User.conf and /etc/dai/Group.conf 继承服务用户与用户组权限。升级期间,您无需手动指定 DAI_USER 或 DAI_GROUP 环境变量。

请注意:如果 Driverless AI 仍在运行,可使用 Ctrl+C 停止 Driverless AI。

要求¶

从 1.7.0 版开始,不再支持 CUDA 9。您的主机环境必须有 CUDA 10.0 或更高版本,并安装有 NVIDIA 驱动程序 (>= 440.82)(仅 GPU)。Driverless AI 自带 CUDA 库,但是主机环境中必须有驱动程序。前往 https://www.nvidia.com/Download/index.aspx, 获取最新的 NVIDIA Tesla V/P/K 系列驱动程序。

升级步骤¶

在 NVIDIA DGX 计算机上,创建 Driverless AI 新版本的目录。

将数据 、日志、许可证和 tmp 目录从之前的 Driverless AI 目录复制到新的 Driverless AI 目录中。

运行

docker pull nvcr.io/h2oai/h2oai-driverless-ai:latest以检索最新的 Driverless AI 版本。启动 Driverless AI Docker 映像。

通过浏览器访问 http://Your-Driverless-AI-Host-Machine:12345,连接至 Driverless AI。